NVIDIA ADA LOVELACE OG GEFORCE RTX 40-SERIES: Alt, hvad vi ved | Tom S Hardware, Asus GeForce RTX 40 -serie grafikkort

Asus GeForce RTX 40 -serie grafikkort

Vi havde to lange år med GPU-tørke og overpris kort til Nvidias tidligere generation Ampere / RTX 30-serie GPU’er. Afslutningen af 2022 markerede ankomsten af den første Next-Gen GPU’er, men de var alle meget dyre, startende ved $ 800 minimum. 2023 formes i mellemtiden til at være bedre for dem, der ønsker at købe en mainstream -opgradering.

Nvidia Ada Lovelace og GeForce RTX 40-serie: Alt, hvad vi ved

NVIDIAs ADA-arkitektur og GeForce RTX 40-serie-grafikkort begyndte først at sende den 12. oktober 2022, startende med GeForce RTX 4090. GeForce RTX 4080 fulgte en måned senere den 16. november 2022, derefter blev RTX 4070 TI (tidligere RTX 4080 12GB) lanceret den 5. januar 2023, og senest var RTX 4070 -lanceringen den 13. april. NVIDIA Ampere Architecture og dybest set lige efter planen i betragtning af afmatningen (eller hvis du foretrækker, død) af Moores ‘lov.’Det er også gode nyheder, da de bedste grafikkort havde brug for en ny konkurrence.

Med NVIDIA HACK Tidligt i 2022 havde vi en god mængde information om, hvad vi kunne forvente. Kort leveres nu, og NVIDIA har bekræftet specifikationer på de mange af RTX 40-serien kort. Vi har samlet alt i dette centrale knudepunkt, der beskriver alt, hvad vi kender, og forventer af Nvidias ADA-arkitektur og RTX 40-serien familie.

Der er stadig rygter, der hvirvler rundt, for det meste om fremtidige ADA Lovelace-kort som de rygtede Titan RTX ADA / RTX 4090 Ti, og de nedre niveauer som RTX 4060-klasse og RTX 4050-og de lavere spec GPU’er er allerede sendt i NVIDIA RTX 40-serie mobile løsninger. Men modellenumre på trods af, har vi nu en god idé om, hvad vi kan forvente af Ada Lovelace -arkitekturen. Med ADA -hvidbogen nu tilgængelig sammen med GPU’erne, har vi opdateret oplysningerne her for at dække nøjagtigt, hvad den nye generation af GPU’er leverer.

Den første salvo af desktop RTX 40-serie-kort har lanceret. Hvis NVIDIA følger en lignende udgivelsesplan som tidligere, kan vi forvente, at resten af RTX 40-serien vil sive ud i det næste år. RTX 4060 TI skulle ankomme i maj med alternative RTX 4060 Ti 16GB og RTX 4060 modeller i juli, og til sidst vil der (måske (måske?) være en 4050 engang i sommer. Lad os starte med oversigt over høje niveauer af specifikationerne og rygte specifikationer for ADA -serien med GPU’er.

GeForce RTX 40-serie specifikationer og spekulation

Stryg for at rulle vandret

| Grafikkort | RTX 4090 Ti / Titan? | RTX 4090 | RTX 4080 | RTX 4070 TI | RTX 4070 | RTX 4060 Ti | RTX 4060 | RTX 4050 |

|---|---|---|---|---|---|---|---|---|

| Arkitektur | AD102 | AD102 | AD103 | AD104 | AD104 | AD106 | AD107 | AD107 |

| TSMC 4n | TSMC 4n | TSMC 4n | TSMC 4n | TSMC 4n | TSMC 4n | TSMC 4n | TSMC 4n | |

| Transistorer (milliarder) | 76.3 | 76.3 | 45.9 | 35.8 | 35.8 | 22.9 | 18.9 | 18.9 |

| Die størrelse (mm^2) | 608.4 | . | 378.6 | 294.5 | 294.5 | 187.8 | 158.7 | 158.7 |

| SMS / CUS / XE-Core | 142 | 128 | 76 | 60 | 46 | 34 | 24 | 18? |

| GPU -kerner (Shaders) | 18176 | 16384 | 9728 | 7680 | 5888 | 4352 | 3072 | 2304? |

| Tensorkerner | 568 | 512 | 304 | 240 | 184 | 136 | 96 | 72? |

| Stråleporing “kerner” | 142 | 128 | 76 | 60 | 46 | 34 | 18? | |

| Boost Clock (MHz) | 2625? / 2520? | 2520 | 2505 | 2610 | 2475 | 2535 | 2460 | 2500? |

| VRAM Speed (GBPS) | 24? | 22.4 | 21 | 21 | 18 | 17 | 16? | |

| VRAM (GB) | 24/48 | 24 | 16 | 12 | 12 | 8 | 8? | |

| VRAM -busbredde | 384 | 384 | 256 | 192 | 192 | 128 | 128 | 128? |

| L2 -cache | 96 | 72 | 64 | 48 | 36 | 32 | 24 | 24? |

| Rops | 192 | 112 | 80 | 64 | 48 | 48 | ? | |

| Tmus | 568 | 512 | 304 | 240 | 184 | 136 | 72? | |

| TFLOPS FP32 (boost) | 95.4? / 91.6? | 82.6 | 48.7 | 40.1 | 29.1 | 22.1 | 15.1 | 11.5? |

| TFLOPS FP16 (FP8) | 763 (1527) / 733 (1466) | 661 (1321) | 390 (780) | 321 (641) | 233 (466) | 177 (353) | 121 (242) | 92 (184)? |

| Båndbredde (GBPS) | 1152 | 1008 | 717 | 504 | 288 | 272 | 256? | |

| TDP (Watts) | 600? / 800? | 450 | 320 | 285 | 200 | 160 | 115 | 80? |

| Frokost aftale | April ~ juni? | 2022 oktober | Nov 2022 | Jan 2023 | Apr 2023 | Maj/juli 2023? | Juli 2023? | ~ Aug 2023? |

| Startpris | En masse | $ 1.599 | $ 1.199 | $ 899 | $ 599 | $ 399/$ 499 | $ 299 | $ 249? |

Alt kort undtagen for RTX 4050 er nu officiel, og specifikationerne er fuldt nøjagtige. Der er rygter om RTX 4050, men specifikationerne er mere formodning baseret på hvad vi kender til den mobile RTX 4050 og desktop RTX 4060. Med andre ord påføres salt generøst på RTX 4090 TI og/eller Titan og 4050 information, da de er mere spekulation end noget konkret. Nvidia har ikke officielt afsløret eksistensen af disse kort, og det er det først, før de er tættere på at frigive.

Der vil sandsynligvis også være yderligere kort, der er annonceret i fremtiden, til midtcyklusopdateringen (i.e. I lighed med 3080 TI og 3070 TI eller før det 2080/2070/2060 supermodeller).

Der er bestemt masser af plads øverst til en fremtidig RTX 4090 ti. Bemærk, at den maksimale L2 -cache er skåret ned på 4090 (tolv blokke på 6 MB i stedet for tolv blokke på 16 MB), ROPS er trimmet lidt, og Nvidia kunne helt sikkert skubbe højere på ure og strøm. og pris. [Suk.] Men selvom troværdige rygter om et 4-slot grundlæggerekort har cirkuleret, er intet officielt i øjeblikket.

Vi ved godt, at Nvidia rammer urhastigheder på 2.5–2.6 GHz på RTX 40-serien GPU’er indtil videre, og vi forventer lignende eller endda højere ure på eventuelle fremtidige GPU’er i opstillingen. Officielle specifikationer og klokkene i den virkelige verden er imidlertid ikke den samme ting, da RTX 4070 for eksempel viser et 2475 MHz boost-ur, mens han tester RTX 4070 Founders Edition rutinemæssigt brød 2700 MHz. NVIDIA har også med succes overklokket RTX 4090 til 3.0GHz og videre. Vi har sat et tentativt estimat af urhastighed på 2.5 GHz på den uanmeldte 4050 GPU for nu.

De seks (syv, hvis du tæller 4060 TI 16GB som et separat kort), der blev frigivet/annoncerede modeller, der bruges fem forskellige GPU’er, hvilket er en ændring fra tidligere lanceringer. RTX 4090 bruger en markant trimmet AD102 -implementering (89% af kernerne, 75% af cachen). I mellemtiden bruger RTX 4080 en “næsten komplet” AD103 -chip (95% af kernerne og al cache), RTX 4070 TI bruger en fuldt aktiveret AD104 -chip, og RTX 4070 bruger 77% af en AD104 -chip. . Igen kan vi forvente enten høstede eller mere fuldt aktiverede varianter af hver GPU på et tidspunkt.

Nvidia “gik stort” med AD102 GPU, og det er tættere i størrelse og transistortællinger til H100 end GA102 var til GA100. Helt ærligt er det et monster med ydeevne og pris, der skal matche. Det pakker i langt flere SMS og de tilknyttede kerner end nogen ampere GPU’er, det har meget højere GPU -ure, og det indeholder også et antal arkitektoniske forbedringer for yderligere at øge ydeevnen yderligere. .

Vores egen test sætter ydeevnen på mere som 60% hurtigere samlet sammenlignet med den forrige generation RTX 3090 TI. . Men som vi bemærkede i vores anmeldelser, mens DLSS 3 -rammegenerering kan øge billedhastighederne, er det ikke det samme som “rigtige” rammer, og det tilføjer typisk latenstid, hvilket betyder, at det føles mere som en forbedring på 10-20 procent i forhold til baseline -ydeevnen. Det er også værd at bemærke, at hvis du i øjeblikket kører en mere beskeden processor snarere end en af de absolut bedste CPU’er til spil, kunne du meget godt ende med CPU -begrænset, selv ved 1440p Ultra med 4090. En større systemopgradering vil sandsynligvis være nødvendig for at få mest muligt ud af den hurtigste ADA GPU’er.

TSMC 4N: “4NM NVIDIA”

. TSMCs 4N -knude er en finjusteret og raffineret variation på TSMCs N5 -knude, der er blevet vidt brugt i andre chips, og som også bruges til AMD’s Zen 4 og RDNA 3. Vi tror ikke, Samsung vil have et overbevisende alternativ, der ikke ville kræve en seriøs redesign af kernearkitekturen, så hele familien vil være på den samme knude.

TSMC N4 tilbyder flere større forbedringer i forhold til Samsung 8N (“8nm Nvidia”), der bruges på ampere. Specifikt har det meget mindre funktioner, hvilket betyder, at Nvidia kan pakke meget flere transistorer i et lignende eller mindre område. AD102 har for eksempel 76.3 mia. AD103/106/107 Tilbyder en lignende 119 ~ 121-densitet, mens AD104 er den mindst tætte chip med “kun” 109 mtrans/mm^2. Ampere GA102/104/106 GPU’er til sammenligning pakket omkring 43 ~ 45 mtrans/mm^2.

N4 -procesnoden muliggør også lavere effektbrug og forbedret effektivitet. Ja, RTX 4090 har et massivt 450W TGP (Total Graphics Power) -budget, men på tværs af en 15 spiltestsuite var det i gennemsnit 390W ved 4K Ultra -indstillinger i vores test. De mest krævende spil kunne trække 450W, mens andre kun havde brug for omkring 300 ~ 325 watt. Og det er det værste eksempel fra ADA; RTX 4080, 4070 TI og 4070 er alle øverst på vores effektivitetsmetrik, med hensyn til FPS pr. Watt.

Endelig, som nævnt ovenfor, er urhastighederne meget højere med ADA end med ampere. Officielle ure er steget fra 1.665–1.860 MHz med ampere (afhængigt af modellen) til et interval på 2.475–2.610 MHz med ADA. Det er i gennemsnit 40 til 50 procent højere ure, skønt de virkelige verden ure for både ampere og ADA har en tendens til at være omkring 200 MHz højere end de officielle boost-ure.

ADA øger massivt beregning af ydeevne

Lad os komme ind i detaljerne med det høje niveau. Den mest bemærkelsesværdige ændring med ADA GPU’er vil være antallet af SMS sammenlignet med den aktuelle ampere -generation. Øverst pakker AD102 potentielt 71% mere SMS end GA102. Selv hvis intet andet skulle ændre sig markant i arkitekturen, ville vi forvente, at det ville levere en enorm stigning i ydeevnen.

Der gælder ikke kun for grafik, men også til andre elementer. De fleste af beregningerne har ikke ændret. Hver 4. generation Tensor -kerne kan udføre 256 FP16 -beregninger pr. Ur, dobbelt så meget med sparsitet og dobbelt så meget med FP8 og sparsitet. RTX 4090 har teoretisk dyb læring/AI -beregning af op til 661 teraflops i FP16, og 1.321 teraflops af FP8 – og en fuldt aktiveret AD102 -chip kunne ramme 1.4 petaflops på lignende ure.

. Det betyder, at RTX 4090 leverer en teoretisk stigning på 107%, baseret på kernetællinger og urhastigheder. Det samme teoretiske løft i ydelsen gælder også for skyggeren og strålesporingshardware, undtagen at de også ændrer.

GPU -shader -kernerne får en ny shader -udførelsesudbestilling (SER) -funktion, som NVIDIA hævder vil forbedre den generelle ydeevne med 25%, og kan forbedre strålesporingsoperationer med op til 200%. Desværre kræver support til SER, at udviklere bruger proprietære NVIDIA -udvidelser, så eksisterende spil kommer ikke nødvendigvis til gode.

RT -kernerne er i mellemtiden fordoblet på Ray/Triangle -kryds -hardware (eller i det mindste gennemstrømningen pr. Kerne), plus de har et par mere nye tricks til rådighed. OPACITY MICRO-MAP (OMM) -motoren muliggør markant hurtigere stråleporing for gennemsigtige overflader som løv, partikler og hegn. Den fordrevne mikro-mesh (DMM) -motor på den anden side optimerer genereringen af afgrænsningsvolumenhierarki (BVH), og NVIDIA hævder, at den kan skabe BVH op til 10x hurtigere, mens du bruger 20x mindre (5%) hukommelse til BVH-opbevaring. .

Sammen skal disse arkitektoniske forbedringer gøre det muligt for ADA Lovelace GPU’er at tilbyde et massivt generationsspring i ydeevne. Bortset fra at det vil være op til udviklere at gøre det muligt for de fleste af dem, så optagelsen kan være temmelig formindsket.

Ada Lovelace Rops

ADAs ROP -tællinger stiger en hel del i nogle tilfælde, især topmodellen (for nu) RTX 4090. Som med ampere binder NVIDIA ROPS til GPC’erne, grafikbehandlingsklyngerne, men nogle af disse kan stadig være deaktiveret. Hver GPC får typisk 16 ROPS.

AD102 har op til 144 SMS med 12 GPC’er på 12 SMS hver. Det giver 192 ROPS som det maksimale, skønt det endelige nummer på RTX 4090 er 11 GPC’er og 176 ROPS. RTX 4080 gas Syv GPC’er, ligesom GA102, men i en underlig tempoændring ser det ud til, at en af GPC -klyngerne kun har 8 SMS, mens de andre seks har op til 12 SMS. Uanset hvad er alle syv aktiveret på RTX 4080, og det har 112 ROPS. AD104 i RTX 4070 TI og 4070 bruger fem GPC’er på 12 SMS, med 80 ROPS.

For tiden skal de resterende kort tages som en bedste gæt. Vi ved ikke med sikkerhed, hvad GPU’er vil blive brugt, eller hvor mange GPC’er der vil være aktive på hver. Vi udfylder emnerne, efterhånden som flere oplysninger bliver tilgængelige i de kommende måneder, når den anden ADA GPU’er har lanceret.

Hukommelsessystem: GDDR6X kører igen

Sidste år annoncerede Micron, at det har køreplaner for GDDR6X hukommelse, der kører med hastigheder på op til 24 Gbps. Den seneste RTX 3090 TI bruger kun 21 Gbps hukommelse, og Nvidia er i øjeblikket det eneste firma, der bruger GDDR6X til hvad som helst. Det rejser straks spørgsmålet om, hvad der vil bruge 24 Gbps GDDR6X, og det eneste rimelige svar ser ud til at være Nvidia Ada. GPU’erne i lavere niveau er mere tilbøjelige til at holde sig til standard GDDR6 snarere end GDDR6X også, der topper ved 20 Gbps og bruges i AMD’s RX 7900 XTX/XT-kort.

Officielt bruger RTX 4090, 4070 TI og 4070 alle 2 GB chips, der er klassificeret til 21 Gbps. RTX 4080 er undtagelsen med 2 GB chips, der er klassificeret til 22.4 Gbps. Bortset fra, Micron tjener ikke 22.. Anekdotisk, i vores adskillelse af flere RTX 40-serie GPU’er, har vi bemærket, at nogle af “21 Gbps” -kortene har hukommelse, der kører køligere og overklokker bedre, og rammer op til 25 Gbps. Vi antager, at Micron bare er nedbinket nogle chips, og det giver på 24 Gbps hukommelse er ganske gode nu.

At have den samme maksimale båndbredde som RTX 3090 Ti repræsenterer lidt af et problem, da GPU’er generelt har brug for beregning og båndbredde for at skalere forholdsmæssigt for at realisere den lovede ydeevne. RTX 3090 TI har for eksempel 12% mere beregning end 3090, og den højere urte hukommelse giver 8% mere båndbredde. Baseret på de computeroplysninger, der er vist ovenfor, er der en enorm afbrydelse af brygning. RTX 4090 har omkring dobbelt så meget beregning som RTX 3090 Ti, men det tilbyder den samme 1008 GB/s båndbredde – 24 Gbps for en eventuel RTX 4090 Ti, nogen?

. Den aktuelle RTX 3050 til RTX 3070 bruger alle standard GDDR6 -hukommelse, klokket til 14–15 Gbps. Vi ved allerede, at GDDR6, der kører med 20 Gbps, er tilgængelig, så en hypotetisk RTX 4050 med 18 Gbps GDDR6 burde let følge med stigningen i GPU -computerkraft. Hvis NVIDIA stadig har brug for mere båndbredde, kan det også trykke på GDDR6X til de nederste niveau GPU’er.

Fangsten er, at Nvidia ikke gør det brug for Massive stigninger i ren hukommelsesbåndbredde, for i stedet omarbejdede den arkitekturen, svarende til hvad vi så AMD gøre med rDNA 2 sammenlignet med den originale rDNA -arkitektur. Nemlig det vil pakke meget mere L2 -cache i for at lindre kravene til hukommelsessystemet.

ADA indgår på L2 -cache

En god måde at reducere behovet for mere rå hukommelsesbåndbredde på er noget, der har været kendt og brugt i årtier. Slap mere cache på en chip, og du får flere cache -hits, og hver cache -hit betyder, at GPU ikke behøver at trække data fra GDDR6/GDDR6X -hukommelsen. En stor cache kan være særlig nyttig til spilpræstation. AMDs Infinity -cache gjorde det muligt for RDNA 2 -chips at grundlæggende gøre mere med mindre rå båndbredde og NVIDIA ADA L2 CACHE .

AMD bruger en massiv L3 -cache på op til 128 MB på NAVI 21 GPU, med 96 MB på Navi 22, 32MB på Navi 23 og kun 16 MB på Navi 24. AMD har også 96 MB L3 -cache på den nye Navi 31. Overraskende gør selv den mindre 16MB -cache vidundere for hukommelsessystemet. Vi troede ikke Radeon RX 6500 XT var et godt kort generelt, men det følger dybest set med kort, der har næsten dobbelt så meget som hukommelsesbåndbredden.

ADA-arkitekturen parrer op til en 8MB L2-cache med hver 32-bit hukommelseskontrol eller 16 MB pr. 64-bit controller. . Bortset fra, at en del af L2 -cache -blokke også kan deaktiveres, så RTX 4090 har kun 72 MB L2 -cache (tolv blokke 6 MB i stedet for 8MB), og nogle af de andre ADA -modeller vil sandsynligvis tage en lignende tilgang.

Mens det er mindre end AMDs rDNA 2 Infinity -cache i mange tilfælde, faldt AMD også til 96 MB i alt L3 -cache for sin top RX 7900 XTX. Vi kender heller ikke forsinkelser eller andre aspekter af designet endnu. L2 -cache har en tendens til at have lavere latenser end L3 -cache, så en lidt mindre L2 kunne bestemt følge med en større, men langsommere L3 -cache, og som vi så med RDNA 2 GPU’er, selv en 16MB eller 32MB Infinity Cache hjalp meget.

Hvis vi ser på AMD’s RX 6700 XT som et eksempel. Det har ca. 35% mere beregning end den forrige generation RX 5700 XT. Præstation i vores GPU Benchmarks Hierarchy I mellemtiden er ca. 32% højere ved 1440p Ultra, så ydelse samlet skaleres stort set i tråd med beregning. Bortset fra 6700 XT har en 192-bit interface og kun 384 GB/s båndbredde, 14% lavere end RX 5700 XT’s 448 GB/s. Det betyder, at den store Infinity -cache gav AMD mindst 50% boost til effektiv båndbredde.

Generelt ser det ud til, at NVIDIA får lignende resultater med ADA, og selv uden bredere hukommelsesgrænseflader skal ADA GPU’erne stadig have masser af effektiv båndbredde. Det er også værd at nævne, at NVIDIAs hukommelseskomprimeringsteknikker i tidligere arkitekturer har vist sig at være i stand, så lidt mindre cacher sammenlignet med AMD betyder muligvis ikke noget.

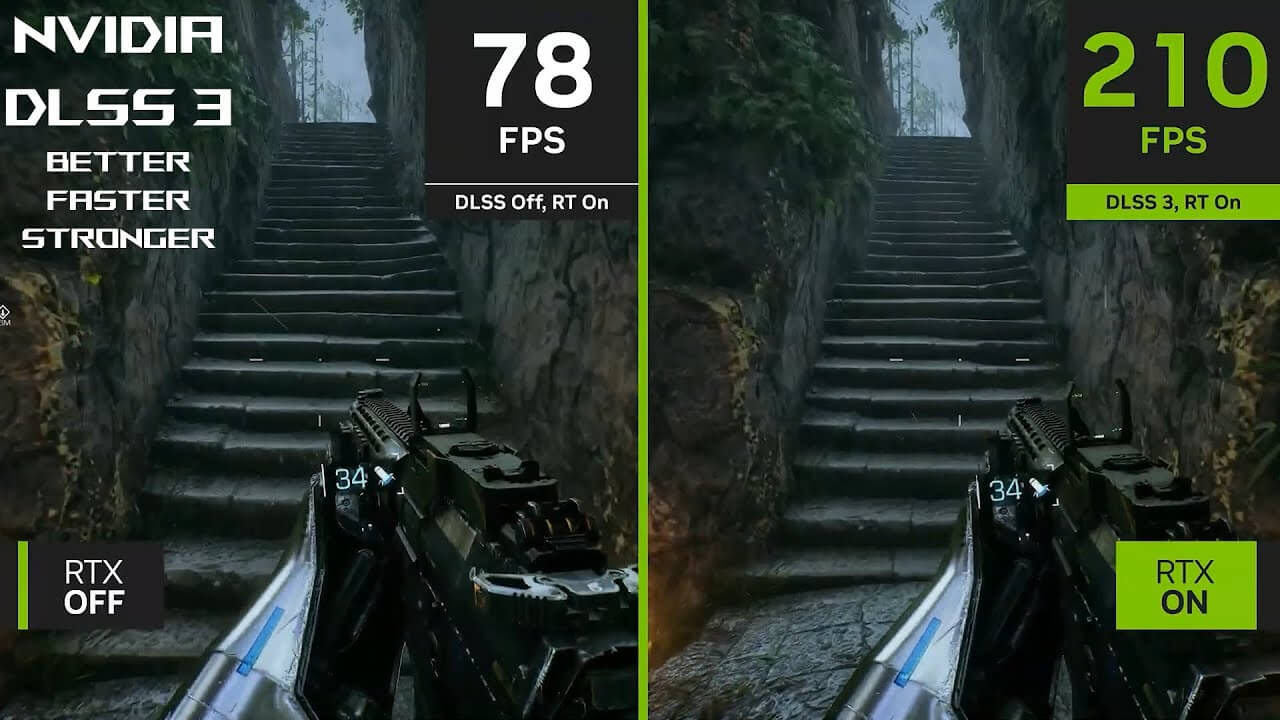

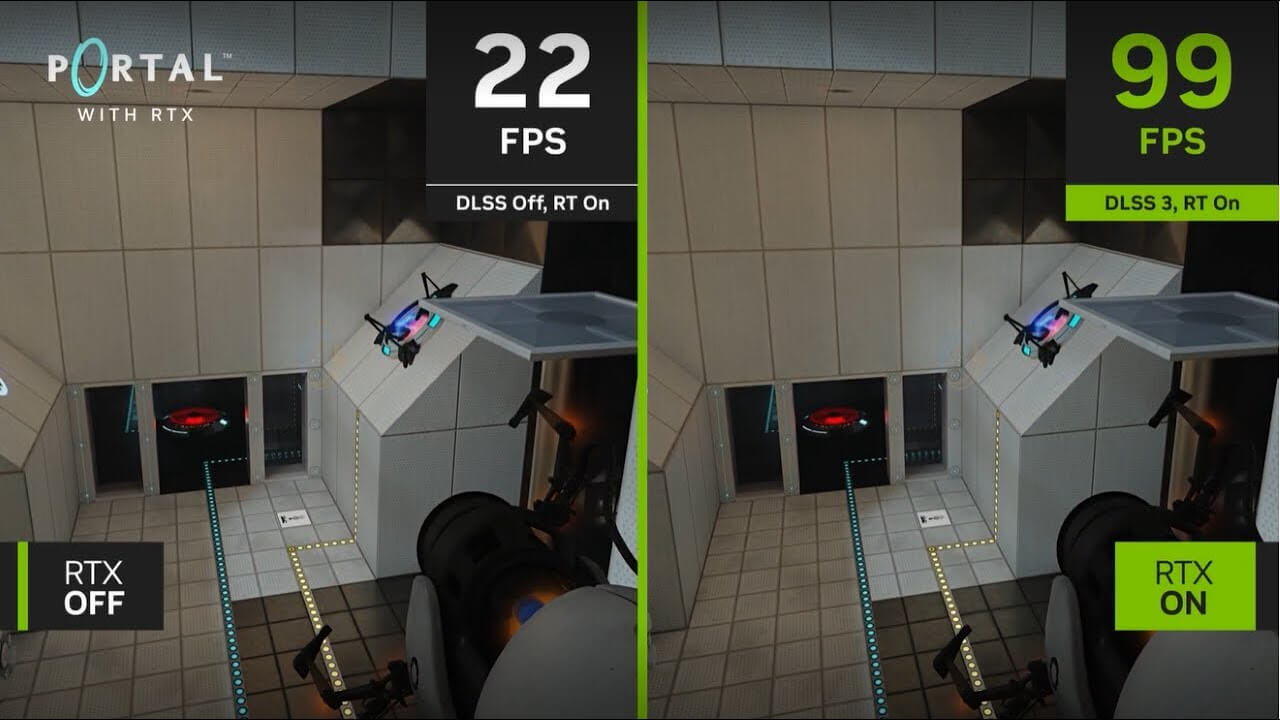

RTX 40-serie får DLSS 3

En af de store meddelelser med RTX 40-serien og Ada Lovelace er DLSS 3, som vil kun Arbejd med RTX 40-serie grafikkort. Hvor DLSS 1 og DLSS 2 arbejder på både RTX 20- og 30-serie-kort, og vil også arbejde på ADA GPU’er, ændrer DLSS 3 grundlæggende nogle ting i algoritmen og kræver tilsyneladende de nye arkitektoniske opdateringer.

Indgange til DLSS 3 -algoritmen er for det meste de samme som før, men nu er der en opdateret optisk flowaccelerator (OFA), der tager to tidligere rammer og genererer yderligere bevægelsesvektorer, der derefter kan fodre ind i den optiske multi ramme -generationsenhed. Kombineret med DLSS Performance Mode -opskalering betyder rammeproduktion, at GPU potentielt kun skal gengive 1/8 af de pixels, der bliver sendt til skærmen.

I øvrigt er OFA ikke Ny med ADA. Turing og Ampere havde også en fast funktion af en blok, kun det var ikke så performant eller så i stand. Typiske brugssager for OFA i fortiden omfattede reduktion af latenstid i augmented og virtual reality, forbedring af glathed ved videoafspilning, forbedring af videokomprimeringseffektiviteten og muliggør videokamera -stabilisering. Det blev også brugt med bilindustrien og robotnavigation og videoanalyse og forståelse.

Ampere -generationen opgraderede OFA til en 126 teraops (INT8) fast funktionsenhed, og nu øger ADA OFA op til 305 teraops. Den tilføjede ydelse og andre forbedringer tillader det at blive brugt til at skabe det optiske flowfelt, der er en del af DLSS 3 -rammegenerering. Mens ADA OFAs højere ydeevne og kapaciteter i øjeblikket er påkrævet til DLSS 3, er der en smule Wiggle Room. Nvidias Bryan Catanzaro, VP for Applied Deep Learning Research, tweetede, at det var “teoretisk muligt” for DLSS 3 at til sidst arbejde på Ampere GPU’er. Det ville sandsynligvis køre på lavere kvalitet og præstationsniveauer, og det kan faktisk aldrig ske.

Vi har nu haft en chance for at se, hvordan DLSS 3 ser ud og føles i handling. Det er ikke så fantastisk som Nvidias påstande. . Tag et spil som En pestfortælling: Requiem Kører på 100 fps med DLSS 2 -opskalering, og rammegenerering kan øge det til 140-150 fps. Men det føles mere som måske 110-120 fps i bedste fald, efter vores mening. Ved lavere pre-frameGen-rammer, som at sige 30 fps, får du muligvis dobbelt så stor som 60 fps, men det vil stadig føles som 30 fps.

. Det vil være en ekstra indstillingsbrugere kan vælge at aktivere; Uden dette understøtter DLSS 3 stadig kerne DLSS 2-opskaleringsalgoritmen og kræver også, at udviklere bruger NVIDIA-refleks, så udviklere vælger DLSS 3 Support RTX 40-serie såvel som tidligere RTX-seriekort.

ADA får AV1 -kodning, gange to

NVIDIAs GeForce RTX 4090, 4080 og 4070 TI-grafikkort indeholder to af dens ottende generation af NVIDIA-koderen (NVENC) hardwareenheder. For RTX 4070 og lavere modeller er der kun en enkelt NVENC -enhed. Disse vil også have støtte til AV1 -kodning, der ligner Intel -buen – undtagen der er to i stedet for kun en. Vi har for nylig udført en dybdegående test af video, der koder for ydeevne og kvalitet, sammenlignet de nyeste GPU’er med tidligere generationer.

AV1 -kodning forbedrer effektiviteten med 40% ifølge Nvidia, men det ser ud til at være sammenlignet med H.264 (det er for det meste ens i bitrates og effektivitet som HEVC/H.265). Det betyder, at enhver livestreams, der understøtter codec, ville se ud som om de havde en 40% højere bitrate end den nuværende h.264 streams. Naturligvis er streamingtjenesten nødt til at støtte AV1 til, at dette betyder noget.

De to kodere kan opdele arbejdet mellem dem, så kodning af ydelsen er potentielt fordoblet for enhver arbejdsbyrde, selvom GPU kun koder for en enkelt strøm. Eller i det mindste er det teorien; I praksis så vi ikke nogen større ændring, når vi brugte FFMPEG sammenlignet med tidligere NVENC -hastigheder. Videoredaktører kan drage fordel af performance boost, og Nvidia arbejdede med DaVinci Resolve, Handbrake, Voukoder og Jianying for at muliggøre støtte.

GeForce Experience og ShadowPlay vil også bruge den nye hardware, så gamere kan fange gameplay på op til 8k og 60 fps i HDR. Perfekt til 0.01% af de mennesker, der kan se native 8k indhold! (Hvis du bygger det, kommer de. ) Også Nvenc -enhederne kan stadig håndtere h.264, HEVC og andre formater helt fint.

ADA strømforbrug

Tidlige rapporter om 600W og højere TBP’er (total bestyrelsesmagt) for ADA ser ud til at være for det meste ubegrundede, i det mindste på de annoncerede Founders Edition -modeller. Faktisk, efter at have testet seks forskellige RTX 4090 -kort, selv med manuel overklokke brød vi ikke konsekvent 600W. RTX 4090 har den samme 450W TGP som den udgående RTX 3090 TI, mens RTX 4080 falder til kun 320W, RTX 4070 TI har en 285W TGP, og RTX 4070 lander på 200W. Disse er til reference Grundlæggers udgavemodeller dog.

Som vi har set med RTX 3090 TI og andre Ampere GPU’er, er nogle AIB (Add-In Board) -partnere mere end glade for at have væsentligt højere magttrækning i forfølgelsen af enhver sidste ounce af præstationer. RTX 4090 brugerdefinerede kort, der trækker op til 600W, er bestemt ikke ude af spørgsmålet, og en fremtidig RTX 4090 Ti kunne skubbe det endnu højere.

Det hele går tilbage til slutningen af Dennard -skalering, lige sammen med døden af Moore’s lov. Kort sagt, Dennard skalering – også kaldet MOSFET -skalering – observerede, at med hver generation kunne dimensioner nedskaleres med ca. 30%. Det reducerede det samlede areal med 50% (skalering i både længde og bredde), spænding faldt en lignende 30%, og kredsløbsforsinkelser ville også falde med 30%. Desuden ville frekvenser stige med ca. 40%, og det samlede strømforbrug ville falde med 50%.

Hvis det hele lyder for godt til at være sandt, skyldes det, at Dennard -skalering effektivt sluttede omkring 2007. . Urhastigheder i integrerede kredsløb er kun steget fra højst 3.7GHz i 2004 med Pentium 4 Extreme Edition til dagens maksimale 5.5GHz i kernen i9-12900ks. Det er stadig næsten 50% stigning i frekvens, men det er kommet over Seks generationer (eller mere, afhængigt af hvordan du vil tælle) Process Node forbedringer. Sagt på en anden måde, hvis Dennard skalering ikke var død, ville moderne CPU’er klokke så højt som 28 GHz. RIP, Dennard skalering, du bliver savnet.

Det er ikke kun den frekvensskalering, der døde, men også strøm- og spændingsskalering. I dag kan en ny procesnode forbedre transistortætheden, men spændinger og frekvenser skal afbalanceres. Hvis du vil have en chip, der er dobbelt så hurtig, skal du muligvis bruge næsten dobbelt så meget strøm. Alternativt kan du opbygge en chip, der er mere effektiv, men det vil ikke være hurtigere. Nvidia ser ud til at gå efter mere præstation med ADA, selvom det ikke har kastet effektiviteten fuldstændigt ud af vinduet.

Bare se på RTX 4070 Ti som et eksempel. Vores test viser, at det er tæt på den forrige generation RTX 3090 TI i ydeevne, mens han trækker 37% mindre strøm. I nogle tilfælde, som med DLSS 3 og tunge RT -arbejdsbelastninger, kan det endda fordoble ydelsen, mens den stadig bruger mindre strøm. .

RTX 40-serie prisfastsættelse

Hvor meget koster RTX 40-serien GPU’er? Det korte svar og rigtigt Svar, er, at de vil koste så meget som Nvidia og detailhandlere kan slippe af sted med opladning. Nvidia lancerede ampere med et sæt økonomiske modeller, og de viste sig at være helt forkerte for den covid pandemiske æra. Priserne i den virkelige verden skød op og scalpers fortsatte, og det var Før Cryptocurrency -minearbejdere begyndte at betale to til tre gange de officielle anbefalede priser.

Den gode nyhed er det GPU -priser er kommet ned, og Ethereum Mining er afsluttet. Det har igen absolut dræbt GPU -rentabilitet for minedrift, med de fleste kort, der nu koster mere at køre, end de kunne gøre af bestræbelserne. Det er godt at høre, men det garanterer stadig ikke rimelige priser.

Hvad gør du, når du har en masse eksisterende kort at sælge? Du får de nye kort til at koste mere. Vi ser det med lanceringspriserne på RTX 4090, 4080, 4070 TI og 4070 modeller. 4090 er $ 1.599, $ 100 mere end 3090 lanceringsprisen og langt uden for rækkevidde af de fleste spillere. RTX 4080 er ikke meget bedre til $ 1.199, og RTX 4070 TI koster $ 799, $ 100 mere end RTX 3080 10 GB lancering MSRP og $ 200 mere end den udgående RTX 3070 Ti – og det var først i slutningen af 2022, at vi endda så 30-serie-kort sælger på detailhandel for tæt på deres MSRP’er!

Det ser ud til, at NVIDIA formåede at rydde nok af sin eksisterende RTX 30-serie-lager, og RTX 40-serie-kortene opretholder deres høje priser. De fleste er nu tilgængelige, der starter ved MSRP, eller i det mindste tæt på det, selvom RTX 4090 stadig kan kommandere en præmie. Det er sandsynligvis fordi det også bliver afhentet til professionelt arbejde, herunder forskning i AI og dyb læring. Den nye RTX 4060 TI og 4060 bringer i det mindste ADA ned til lignende prispoint som deres forgænger.

Generelt er generationsgpu-priserne steget med ADA og RTX 40-serien (4060-serien er undtagelsen). Nvidia er også nødt til at konkurrere med AMD og Radeon RX 7000-serien og rDNA 3 GPU’er, men det er også dyre. Nvidia var langsommere for at skubbe yderligere GPU’er ud som RTX 4070 og derunder, skønt mainstream 4060 TI og nedenfor er tilbage til prisparitet med deres forgænger. Forhåbentlig vil de fremtidige modeller (især RTX 4050 fortsat tendens nedad og nå frem til mere rimelige niveauer af omkostninger uden fuldstændigt at akse ydelse.

Founders Edition Design Ændringer

NVIDIA fremsatte en masse påstande om dets nye Founders Edition -kortdesign ved lanceringen af RTX 3080 og 3090. Mens kortene generelt fungerer fint, er det, vi har opdaget i de sidste to år. Det GeForce RTX 3080 TI Founders Edition Var et særligt uregelmæssigt eksempel på, hvordan temperaturer og ventilatorhastigheder ikke kunne følge med med varmere kørsel GPU’er.

Den vigtigste skyldige ser ud til at være GDDR6X -hukommelsen, og Nvidia pakker ikke ikke mere . Nvidia bemærker dog, at det har arbejdet med Micron (den eksklusive producent af GDDR6X) for at reducere strømforbruget fra den seneste generationschips. Det burde helt sikkert hjælpe sager, og mens Micron gør 24 Gbps GDDR6X, hidtil ikke går så højt på hukommelsesurene.

RTX 4090 har tolv 2 GB chips, ligesom 3090 TI, mens 4080 nedskærer det til otte chips og 4070 Ti skal kun afkøle seks chips. Med en proces krympet fra mikron på GDDR6X-chips, plus bedre termiske puder, får vi RTX 40-serie-kort, der generelt ikke kører næsten lige så varme som de tidligere modeller. NVIDIA reducerede også termisk pude-tykkelse med RTX 40-serien for bedre hjælp til varmeoverførsel fra hukommelsen til kølepladen.

. . Vores antagelse er, at de lavere temperaturkort faktisk bruger Microns 24 Gbps -chips med en forbedret procesnode, lige markeret og solgt som 21 Gbps. RTX 4080 indtil videre er det eneste kort, der kræver hurtigere chips, og disse kort også har en tendens til at ramme

Hvad angår kortdesign, kommer selv RTX 4080 ind på triple-slot-handlingen denne runde, som er en interessant tempoændring. Det er ‘kun’ en 320W TBP, men derefter løb 3080 FE og 3080 ti fe altid mere end lidt toasty. 285W TBP på 4070 TI får muligvis to-slot-behandlingen fra nogle af AIB-partnerne, men Nvidia laver ikke en 4070 TI Founders Edition-den bestemte GPU kommer kun fra tredjepartskort. RTX 4070 har en Founders -udgave, og RTX 4060 TI 8GB har også en Founders -udgave. RTX 4060 TI 16GB og RTX 4060 vil kun blive tilbudt som brugerdefinerede kort fra NVIDIAs AIB Partners.

ADA GPU -udgivelsesdatoer

Nu hvor den store afsløring og indledende lanceringer er forbi, ved vi, at RTX 4090 ankom den 12. oktober, RTX 4080 blev lanceret den 16. november, og RTX 4070 TI ankom den 5. januar (efter at have ændret navnet fra RTX 4080 12 GB og faldet MSRP $ 100). RTX 4070 landede den 13. april, og RTX 4060 TI 8GB lanceres den 24. maj. Vi ved, at RTX 4060 TI 16GB og RTX 4060 ankommer i juli, men vi har ikke nøjagtige datoer endnu. RTX 4050 til desktops kunne spekulativt land i august. Der kan også være andre ADA -grafikkort.

NVIDIA lancerede RTX 3080 og RTX 3090 I september 2020 ankom RTX 3070 en måned senere, derefter ankom RTX 3060 TI lidt over en måned efter det. RTX 3060 kom først ud i slutningen af februar 2021, derefter opdaterede NVIDIA serien med RTX 3080 TI og RTX 3070 TI i juni 2021. Den budgetvenlige RTX 3050 ankom først før januar 2022, og til sidst blev RTX 3090 Ti lanceret i slutningen af marts 2022.

Nvidia har valgt en forskudt lancering til ADA-kortene, forsinket lidt på nogle modeller for at give overforsyningssituationen Nvidia stod overfor på RTX 30-serie dele i 2022 for at korrigere. Det er nu forbi og gjort så vidt vi kan fortælle, og vi venter bare på, at de endelige modeller dukker op.

Vi har stadig brug for ægte budgettilbud for at overtage GTX 16-serien. Kunne vi få en ny GTX -serie eller et ægte budget RTX -kort til under $ 200? Det er muligt, men regner ikke med det, da Nvidia ser ud til at være tilfreds med at lade AMD og Intel bekæmpe det i området under $ 200. I bedste fald falder RTX 3050 muligvis til $ 200 i de kommende måneder, men vi ville ikke blive overrasket over at se NVIDIA helt opgive det under $ 200 grafikkortmarked. Vi har mistanke.

Der er normalt en opdatering af GPU’er omkring et år efter den første lancering, og vi kommer tæt på dette mærke nu. Uanset om disse ender med at blive “Ti” -modeller eller “super” modeller eller noget andet er nogens gæt, men du kan stort set markere det på din kalender. GeForce RTX 40-serie-opdatering, der kommer i efteråret 2023.

Konkurrence i GPU -rummet

Nvidia har været den dominerende spiller i grafikkortpladsen i et par årtier nu. Det kontrollerer ca. 80% af det samlede GPU -marked og 90% eller mere af det professionelle marked, hvilket stort set har gjort det muligt for det. Men med den fortsatte stigning i vigtigheden af AI og beregning af videnskabelig forskning og andre beregningsmæssige arbejdsbelastninger, og deres afhængighed af GPU-lignende processorer, ser adskillige andre virksomheder ud til at bryde ind i branchen, hvor chef blandt dem er Intel.

Intel havde ikke gjort et ordentligt forsøg på et dedikeret grafikkort siden slutningen af 90’erne, medmindre du tæller den forladte Larrabee. Denne gang ser Intel Arc Alchemist ud til at være den rigtige aftale – eller i det mindste foden i døren. Intel tilbyder gode mediefunktioner, og ARCs spil og generelle beregningspræstationer er fine, men de er bestemt ikke tilstrækkelige til at konkurrere med avancerede AMD- og Nvidia-kort. I stedet går Intel til mainstream til budgetsektoren. for nu.

Men Arc Alchemist er kun den første i en almindelig kadence af GPU -arkitekturer, som Intel har planlagt. Battlemage kunne let fordoble Alchemists kapaciteter, og hvis Intel kan få det ud før end senere, kunne det begynde at spise i Nvidias markedsandel, især i spillelaptoprummet. JPR angiver, at ARC opnåede en temmelig imponerende 6% af det globale salgsmarked i slutningen af 2023, men at droppe priserne antyder, at udsalg for ARC ikke er næsten lige så høj.

. AMD er flyttet til TSMCs N5 -knude for GPU -chipletterne, men det vil også bruge N6 -noden til hukommelseschipletterne. AMD nægter stadig at lægge nogen betydelig mængde af dyb indlæringshardware i sine forbruger -GPU’er (i modsætning til sin MI200 -serie), som giver den mulighed for at fokusere på at levere ydeevne uden at bekymre sig så meget om opskalering – skønt FSR 2.0 dækker det så godt og fungerer på alle GPU’er. Men i AI -rummet betyder det, at AMDs forbruger GPU’er falder bagefter.

AMD har også RX 7600 snart ved hjælp af TSMC N6 – ikke en massiv opdatering fra den forrige generation, med andre ord. Indtil videre har AMD kun annonceret eller frigivet mobile varianter af sine RX 7700 og 7800 klasse GPU’er.

Der er heller ingen tvivl om, at NVIDIA i øjeblikket leverer langt overlegen strålesporingspræstation end AMDs RX 7000- og 6000-serie-kort. AMD har ikke været næsten lige så vokal om Ray -sporingshardware eller behovet for RT -effekter i spil. Intel for sin side leverer anstændigt (mainstream) RT -ydeevne, men kun op til niveauet for RTX 3060, give eller tage. Men så længe de fleste spil fortsætter med at løbe hurtigere og se godt ud uden RT -effekter, er det en op ad bakke, der overbeviser folk om at opgradere deres grafikkort.

NVIDIA RTX 40-serie Lukning af tanker

Vi havde to lange år med GPU-tørke og overpris kort til Nvidias tidligere generation Ampere / RTX 30-serie GPU’er. Afslutningen af 2022 markerede ankomsten af den første Next-Gen GPU’er, men de var alle meget dyre, startende ved $ 800 minimum. 2023 formes i mellemtiden til at være bedre for dem, der ønsker at købe en mainstream -opgradering.

Forhåbentlig vil denne runde se langt bedre tilgængelighed og prisfastsættelse. Det kunne næppe være værre end hvad vi så i 2020–2022.

Asus GeForce RTX 40 -serien

Asus udnytter den ekstraotrdinære magt fra Nvidia GeForce RTX ™ 40 -serien GPU’er til at levere grafikkort med et utal af avanceret tech, gennembrud. Fra den væskekølede Matrix RTX 4090 Med de højeste out-of-box boost ure på markedet, til de minimalistiske Proart-skaberfokuserede kort, vil brugere af enhver stribe finde noget fra ASUS, der overgår forventningerne. Axial-tech-fans, dampkammerkøling, smart kompakte design, GPU Tweak III-app, fuld Nvidia Studio-support-det hele er her og venter på dig.

HKEPC -redaktørens valg

Rog Strix GeForce RTX 4090 OC Edition tilpassede de nyeste 3.5 slot Axial-Tech-fans, som er stærke kølefunktioner

8.5 ud af 10

Det har alt hvad du muligvis kan ønske dig fra et brugerdefineret kort, såsom en fabriksoverklokke, en meget dygtig og stille køler og et attraktivt design. Dens nye look er en forfriskende afgang fra tidligere Rog Strix -kort, og den beskedne RGB -belysning giver en mere smagfuld og dæmpet æstetisk.

2023 Red Dot Produktdesign

Rog Strix GeForce RTX 40-serien vandt prisen for Red Dot Product Design, en verdenskendt designpris.

Redaktørens valg

Den nye Asus Republic of Gamers (ROG) Strix GeForce RTX 4090 OC repræsenterer den allerbedste luftkølede specialdesign implementering af det nye Nvidia-flagskib, som ASUS har at tilbyde, og vi gennemgår det i dag.

Et fremragende eksempel i byggekvalitet

Dette er versionen til overclockers takket være den fremragende afkøling og lav støjproduktion.

93/100

Asus Rog Strix RTX4090 OC har også et meget cool udseende, med et semi-retro afrundet kabinet og RGB glødende gitter bagpå for et cyberpunk industrielt niveau design samt en anstændig kølingsydelse. Hvis du tænker på at opgradere dit gamle grafikkort, er dette bestemt et godt valg.

91%

Asus slår ned med sit flagskib Rog Strix GeForce RTX 4090 OC Edition Graphics Card, hvor design af kortet tager centrum. .

præstation først

Denne gang lancerede NVIDIA en ny generation af RTX 40 -serien grafikkort, og ASUS lancerede også flagskibet ROG Strix GeForce RTX 4090 OC Graphics Card. For at imødekomme den nye high-end kerne RTX 4090 har den nyligt designede radiator en større størrelse, og boost-ur når 2640 MHz under tuning, der presses så meget ydelse som muligt for spillere.

Red Dot Design Award: Tuf Gaming GeForce RTX 40 -serie

Tuf Gaming GeForce RTX 40-serien vandt prisen for Red Dot Product Design, en verdenskendt designpris.

Asus GeForce RTX 4070 Dual Review – Value & Conklusion | TechPowerup

ASUS -dobbelt skiller sig ud takket være sin ekstremt lave støj, dobbeltbios og korte formfaktor.

Videoer

Asus Proart med NVIDIA Studio

Asus Rog med NVIDIA DLSS 3 – Bedre. Hurtigere. Stærkere.

ROG Strix GeForce RTX 4090 & NVIDIA DLSS 3

Asus Rog med Nvidia Reflex

Styring af kreativitet med Asus Proart | Modsbyben

Asus Tuf Gaming GeForce RTX 4060 TI – Officiel Unboxing

Asus GeForce RTX ™ 4080 NOCTUA EDITION | Første kig

Axial-tech-opgraderinger

Større og bedre. Axial-tech-fans drejer på dobbeltkuglelejer og er blevet skaleret op til at drive 23% mere luft gennem kortet, hvilket sætter scenen for lavere temperaturer, mindre støj og højere ydeevne.

Omvendt rotation og 0db -teknologi

De to sider fans spin mod uret for at minimere turbulens og maksimere luftdispersion gennem kølepladen. Alle tre fans er stille, når GPU-temps er under 50 Celsius, så du kan spille mindre krævende spil eller udføre lette opgaver i relativ tavshed. Fans starter igen, når temps er over 55 ° C, der refererer til en hastighedskurve, der afbalancerer ydeevne og akustik til arbejde eller leg.

Premium strømforsyning

Digital effektstyring, en række højstrøms kraftfaser og en serie på 15K kasketter sikrer massive reserver til pålideligt at skubbe ydelsesgrænser.

Kompakt PCB

Komponent- og sporlayouts er optimeret på En kort PCB at reducere strømtab og lade varme flygte igennem En massiv bagpladeudluftning.

Følg strømmen

Det hele samles for ubesværet at drive GeForce RTX 4090 ydelse til Max.

Asus GPU Tweak III

ASUS GPU Tweak III (download) er mere intuitiv og funktionsrig end nogensinde før. En fornyet grænseflade giver større tilgængelighed ved at integrere kernefunktioner i et centraliseret instrumentbræt, og vores spændingsfrekvensstuner er blevet revideret for at gøre overklokke endnu lettere. Yderligere godbidder som 0DB-fan-teknologi, automatisk profilbytte, en fuldt tilpasselig skærm på skærmen og loggingsfunktioner sikrer, at du får mest ud af dit grafikkort.

Realistisk forsvarer og bankende 40 -serie prisfastsættelse. (Long læst / diskussion)

Diskuter virkelig, TLDR er på forhånd, så hvis du ikke ønsker at læse for at dræbe tid, skal du bare passere, ikke TLDR, fordi du ikke har noget andet bedre at gøre, ville blive værdsat.

Jeg mener, fortid til nutiden . Du har det første 1K -spilkort, 2080ti, som ikke fik så meget flack for at være 1199, (jeg mener ikke at få det snoet, der var noget råb), men ikke som råbet over 40 serier. Men alt det, der blev overskygget af Titan RTX “$ 2499”, men det anbefales ikke til spillere, selvom det slår (byg) en 2080ti i spil. Anywho 75% af mennesker klagede, forbandet, 1k for 2080ti, men sparede stadig for at få en!

Gå videre, siger Nvidia, hej, vi giver dig et endnu mere kraftfuldt kort til halvdelen af prisen! Yay!, Men ingen forudså krypto B.s. Ville skubbe en $ 700 3080 opad til $ 2k, og det gjorde, problemet er den store mængde mennesker, der betalte disse priser, når de havde nøjagtigt det samme valg, ligesom nu, “Køb ikke en 4080, lad os undervise dem En lektion “, når dette skulle være gjort, da 3070’erne skubbede $ 1500 og 3090 og skubbede $ 3K.

Lad os afvikle det, fra et virksomheds synspunkt, HRRMM, lad os frigive 3090 ti til $ 2k og se, hvad der sker. De solgte.. Så hvis “jeg” var Nvidia, ja sir, denne demoniske 4090 (Fe) er en Helluva -aftale, hvis du sutters, der købte 3090ti på 2k og købte 3070’erne til $ 1K, så som en forretning, hvorfor skulle jeg ikke skubbe den bedste kortperiode kl. 1599. Jeg mener, du får et Titan -klassekort til mindre end 2K, hvilket altid har været vores Titan -klassepriser.

Gå videre, 3080 Ti frigivet og blev accepteret 50%, fordi hey ,, det er dybest set en 3090 for langt mindre, kun mangler halvdel had. Hrmm. giver ingen mening.

4070 Ti er en dyremorder på 2080ti og billigere, så jeg føler mere, så folk klager over, at “80” -klassen på kortet er $ 1200 vs det faktum, at det 80 klassekort er Titan -status. Hvis 4080 var mindre kraftfuld eller lig med 3090, da cyklussen stort set altid har været, og 4080 var prissat til $ 100 mere end 3080, ville det være den normale årlige begivenhedscyklus, men 40 -serien kastede dybest set Titan+ Power i en 80/ 90 klassekort og stødte prisen som sådan. Men alt, hvad vi ser, er “80” eller “90” og med en 1.2k prismærke hvilken 80 klasse ikke skal være.

Så de testede markedet med 2080 Ti, folk købte det, skalping bare viste dem, welp, så fattige som ppl er, de betalte stadig disse priser, så 799, 1299 og 1599 er helt fint, plus strømforsyningen. .

Men da mobiltelefoner ramte 1K og blev, er det eneste #, der skubber forbi 1K til telefoner mere TB -opbevaring, men basen er 1K dybest set til en flagskibstelefon. Jeg føler, at GPU’er skal være de samme, hvilket betyder, at 1K burde være det maksimale, men hvis du har brug for mere RAM (for PPL, der faktisk arbejder med GPU) betaler 1200 for 16 GB, 1400 for 24 GB, men uanset hvad de alle 4090 eller hvad som helst. GPU -priser er for forbandede høje, men det er forretning, kan ikke lide det, lav din egen GPU.

2080 TI $ 1200 – Accepteret af 80% af befolkningen, 3080 $ 700, accepteret af 100% af befolkningen, men fra lanceringen gjorde lavt lager det $ 1000, og 75% af mennesker købte stadig stadig. Crypto mining det ramte $ 1600-1800, og 50% af mennesker købte det stadig, så hvem er skyld er, at det? Bestemt ingen nvidia, men vores stumme æsler (ikke persay dig eller mig) men os som forbrugere som helhed.

Hvad vi laver med 4080 nu, skulle vi have gjort med 30 -serie hovedbund “år”, men nooooooo i et helt forbandet år betalte folk udlandske priser, så ikke underligt Nvidia prissat som sådan.

. Lad os komme til bunden af det!

Min personlige tanke: 4080 Pris er for høj, men fair fra Nvidia View, og vi kunne have haft en 999 4080 havde så mange mennesker ikke betalt hovedbundspriserne regelmæssigt.